人工智能基础软件开发测试 基础效果篇

人工智能基础软件的开发测试是确保AI系统可靠性和有效性的关键环节。基础效果测试作为测试体系的第一阶段,聚焦于评估模型的核心能力、性能指标和基础功能的实现程度。本文将系统介绍基础效果测试的主要维度、方法和实践要点。

一、测试目标与范围

基础效果测试的核心目标是验证AI基础软件在理想条件下的表现,包括模型的准确性、稳定性、响应速度等基础指标。这一阶段通常不涉及复杂的环境干扰或极端用例,而是关注模型在标准数据集和常规任务中的表现。测试范围涵盖数据处理、模型训练、推理输出等核心流程。

二、主要测试维度

- 功能正确性测试:验证模型能否完成预期任务,如图像分类的准确率、自然语言处理的语义理解能力等。

- 性能基准测试:包括推理速度、内存占用、吞吐量等量化指标,确保软件满足基础性能要求。

- 鲁棒性初步测试:通过输入轻微扰动数据,检验模型的稳定性和抗干扰能力。

- 可重复性验证:确保相同输入在不同运行环境下能产生一致的结果。

三、典型测试方法

- 单元测试:针对模型中的单个组件或算法进行隔离测试。

- 集成测试:验证多个模块协同工作的效果。

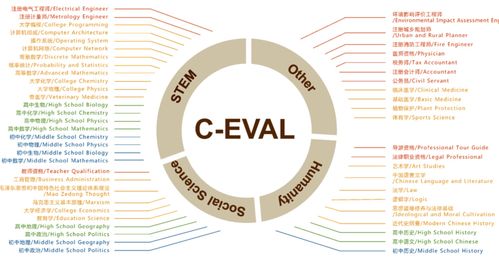

- 基准测试:使用标准数据集(如MNIST、CIFAR-10等)进行量化评估。

- A/B测试:对比不同模型版本或参数配置的表现差异。

四、测试数据管理

高质量的数据是基础效果测试的基石。需要构建具有代表性的测试数据集,涵盖正常用例和边界情况。同时应建立数据版本管理机制,确保测试结果的可比性和可追溯性。

五、指标体系建设

建立全面的评估指标体系至关重要,应包括:

- 准确率、精确率、召回率等传统指标

- 推理延迟、资源消耗等性能指标

- 模型收敛速度等训练效率指标

六、持续集成实践

将基础效果测试纳入持续集成流程,实现自动化测试和快速反馈。通过设置质量阈值,确保每次代码提交都不会导致模型效果显著下降。

七、常见挑战与对策

- 测试环境一致性:通过容器化技术确保测试环境标准化

- 大数据集处理:采用分布式测试框架提高测试效率

- 指标选择困难:结合业务场景选择最相关的评估指标

基础效果测试为后续的进阶测试奠定了坚实基础。只有通过严格的基础效果验证,才能确保AI基础软件具备可靠的核心能力,为更复杂的应用场景提供有力支撑。在后续章节中,我们将深入探讨鲁棒性测试、安全测试等更高级的测试主题。

如若转载,请注明出处:http://www.acvkj.com/product/19.html

更新时间:2026-03-01 03:06:04